Doch während sich der UNS als bewährte Dateninfrastruktur etabliert, bleibt die Entwicklung innovativer Industrie 4.0 Anwendungen auf Basis von UNS-Daten eine anspruchsvolle Aufgabe. Der Grund: Bei der Umsetzung dieser Anwendungsfälle treffen verschiedene Datenverarbeitungskonzepte mit unterschiedlichen Anforderungen an die Datenverarbeitung aufeinander:

- Online/Streaming-Daten für unmittelbare Analysen und Reaktionen, z. B. Echtzeit-Sensordaten und Event-Streams

- Batch-Daten für periodische Auswertungen, z. B. aus SQL-Datenbanken oder ERP-Systemen

- Big Data für umfassende Analysen und KI-gestützte Vorhersagemodelle, z. B. mittels Data Lakehouse-Architekturen

Die Integration dieser Konzepte in den UNS ist anspruchsvoll und bringt technische sowie organisatorische Herausforderungen mit sich. Dieses Whitepaper zeigt, wie die Erweiterung des UNS zum #shared.UnifiedNamespace (#shared.UNS) diese Herausforderungen adressiert und Unternehmen eine effiziente, skalierbare und zukunftssichere Datenstrategie ermöglicht.

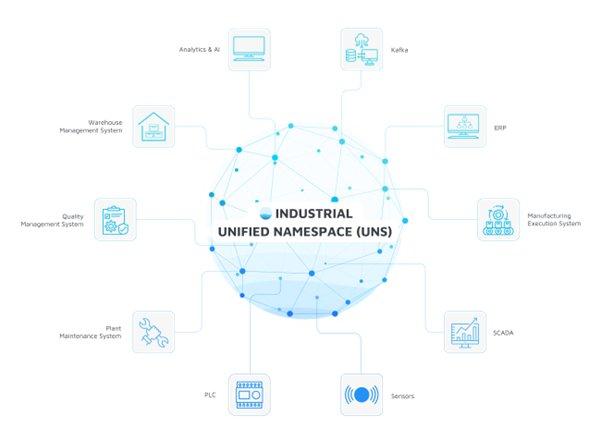

Der Industrial Unified Namespace (UNS)

Die moderne Industrie produziert und verarbeitet enorme Mengen an Daten – von Sensordaten über Produktionskennzahlen bis hin zu unternehmensweiten ERP-Informationen. Doch oft bleiben diese Daten in Silos gefangen, verteilt auf verschiedene Systeme und Plattformen, die nur begrenzt miteinander kommunizieren können. Der Industrial Unified Namespace schafft eine einheitliche Schnittstelle, die alle relevanten Daten in Echtzeit zugänglich macht und so die Grundlage für eine vernetzte, datengetriebene Produktion bildet.

Was ist der UNS?

Ein Industrial Unified Namespace dient als Single-Source-of-Truth für alle Daten in einer Industrieumgebung. Alle relevanten Produktions- und Geschäftsdaten werden dabei in einer einheitlichen, hierarchischen Namensstruktur organisiert und in Echtzeit bereitgestellt. Technisch realisiert wird dies meist durch einen zentralen Message Broker (häufig ein MQTT-Broker), der als Daten-Hub für sämtliche Kommunikationsströme dient. Über diesen Broker veröffentlichen Datenproduzenten (z.B. Sensoren, Maschinen, SPSen) ihre Informationen, und Datenkonsumenten (z.B. MES, Analytics-Plattformen) abonnieren sie – entkoppelt und ereignisgesteuert über das Publish/Subscribe-Muster. Dadurch ersetzt der UNS zahlreiche individuelle Punkt-zu-Punkt-Schnittstellen durch eine zentrale Integrationsschicht.

Kernaspekte und Vorteile des UNS:

Der UNS bietet zahlreiche Vorteile, darunter die nahtlose Datenintegration, Interoperabilität, Skalierbarkeit und eine offene Architektur. Diese Vorteile tragen dazu bei, die Effizienz der Datenverwaltung zu steigern und die Geschäftsprozesse zu optimieren.

- Single-Source-of-Truth: Durch die Zusammenführung von Echtzeitdaten und historischen Daten in einem einzigen, zentralen Repository ermöglicht der UNS den standardisierten Datenaustausch für alle Systeme und Nutzer. Dies führt zu einer verbesserten Zusammenarbeit und effizienteren Betriebsabläufen, da Informationen schnell und präzise verfügbar sind.

- IIoT-Integration: Durch die direkte Einbindung von Industrial IoT (IIoT)-Geräten unterstützt der UNS die Sammlung und Analyse von Daten in Echtzeit. Dies ermöglicht proaktive Wartung, vorausschauende Analysen und Prozessoptimierung.

- Interoperabilität mit IT-Systemen: Im UNS können Systeme unterschiedlicher Hersteller über eine standardisierte Schnittstelle miteinander kommunizieren – unabhängig davon, ob es sich um IIoT-Geräte, MES- oder ERP-Systeme handelt. Dieses ermöglicht eine durchgängige Automatisierung, Prozessoptimierung und datenbasierte Entscheidungsfindung.

Herausforderungen des Industrial Unified Namespace

Trotz der zahlreichen Vorteile bringt die Einführung eines Industrial Unified Namespace auch Herausforderungen mit sich. Eine zentrale Herausforderung ist die Gewährleistung einer performanten, skalierbaren und sicheren Dateninfrastruktur, die den Anforderungen verschiedener Anwendungsfälle gerecht wird. Hierbei haben Anwendungsfälle häufig individuelle Anforderungen an die Ausfallsicherheit, Latenzen, Datenstruktur, -formate, etc. Wie kann in einem zentralen Namespace diese Individualität gewährleistet werden? Zudem unterscheiden sich die Zielnutzer der Daten, was die Standardisierung und Datenharmonisierung innerhalb des UNS erschwert. Und nicht zuletzt stellt die Integration und Kombination verschiedener Datenverarbeitungskonzepte wie Streaming, Batch und Big Data Unternehmen häufig vor Herausforderungen.

- Streaming-Daten

- Datenverarbeitung: Streaming-Daten beziehen sich auf kontinuierliche Datenströme, die in Echtzeit erfasst und verarbeitet werden. Diese Art von Daten ist besonders nützlich für Anwendungen, die sofortige Reaktionen erfordern, wie z.B. Echtzeit-Überwachung, IIoT und Prozesssteuerung. Streaming-Daten werden oft in kleinen, inkrementellen Blöcken erfasst und verarbeitet, welches eine schnelle Analyse und Reaktion ermöglicht.

- Speicherung: Sofern eine Kurzzeit-Speicherung erforderlich ist, werden nur die Echtzeit-Daten in Low-Latency-Datenbanken, wie TimescaleDB oder InfluxDB, gespeichert. Diese sind speziell für zeitreihenbasierte Datenströme optimiert. Zudem kann eine Kurzzeitspeicherung im Cache sinnvoll sein, um schnelle Zugriffe zu gewährleisten. Sofern notwendig, können diese Echtzeit-Daten parallel in das Data-Lakehouse fließen

- Beispiel: Ein Beispiel für die Nutzung von Streaming-Daten ist die Überwachung von Produktionslinien in einer Fabrik. Sensoren an den Maschinen erfassen kontinuierlich Daten wie Temperatur, Druck und Geschwindigkeit. Diese Daten werden in Echtzeit an ein zentrales System gesendet, das Anomalien erkennt und sofortige Maßnahmen ergreift, um Ausfälle zu verhindern und die Effizienz zu steigern.

- Herausforderung im UNS: Die größte Herausforderung ist die Kombination von Echtzeit- und Batch- bzw. historischen Daten. Der UNS muss in der Lage sein, kontinuierlich einfließende Daten mit bereits existierenden Informationen zu verknüpfen, ohne dass Latenz oder Dateninkonsistenzen entstehen. Zudem müssen Mechanismen wie Event-Driven Architekturen und Datenstrom-Semantik (Exactly-Once-Processing, At-Least-Once-Processing) berücksichtigt werden.

- Batch-Daten

- Datenverarbeitung: Batch-Daten werden in regelmäßigen Intervallen verarbeitet und folgen festen Ladezyklen. Typischerweise erfolgt die Verarbeitung durch ETL-Prozesse (Extract, Transform, Load), die Daten aus operativen Systemen extrahieren, transformieren und in strukturierte Speicher überführen.

- Speicherung: Meist in relationalen Datenbanken, die eine strukturierte Speicherung mit vordefinierten Schemata ermöglichen. Diese Datenbanken verwenden Tabellen, um Daten in einer organisierten und leicht zugänglichen Weise zu speichern. Relationale Datenbanken sind ideal für Anwendungen, die komplexe Abfragen und Transaktionen erfordern, wie z.B. ERP- und CRM-Systeme sowie KPIs.

- Beispiel: Batch bzw. relationale Daten ermöglicht es Unternehmen, umfassende Analysen durchzuführen und fundierte Entscheidungen zu treffen. Damit kann ein Unternehmen beispielsweise die Fertigungszeiten über verschieden Anlagen analysieren, um Trends zu erkennen und Probleme abzustellen.

- Herausforderung im UNS: Die Herausforderung liegt in der Synchronisation mit Echtzeitdaten. Beispiel: Die Integration von Polling-Daten (Batch-Daten) in Event-Based-Daten (Streaming-Daten). Batch-Daten müssen so in den UNS integriert werden, dass sie mit Streaming-Daten harmonieren und keine Informationslücken zwischen Aktualisierungszyklen entstehen.

[*]Big Data (z. B. Data Lakehouse-Architekturen)

- Datenverarbeitung: Big Data bezieht sich auf große Mengen unstrukturierter oder semi-strukturierter (Roh-)Daten, die aus verschiedenen Quellen stammen und in großen Volumina, hoher Geschwindigkeit und großer Vielfalt vorliegen. Diese Daten erfordern spezielle Technologien für die Verarbeitung und Analyse, wie Apache Spark oder Hadoop, die parallele Datenverarbeitung ermöglichen.

- Speicherung: Diese Daten werden häufig in einem Data Lakehouse gespeichert. Ein Data Lakehouse kombiniert die Vorteile eines Data Lakes und eines Data Warehouse, indem es sowohl strukturierte als auch unstrukturierte Daten speichert und verarbeitet. Es bietet eine einheitliche Plattform für die Datenverwaltung, wodurch Unternehmen ihre Daten effizienter nutzen können.

- Beispiel: Durch die Integration von Echtzeit- und historischen Daten können Unternehmen Produktionsprozesse kontinuierlich überwachen und optimieren. Ein Data Lakehouse kann dabei helfen, Engpässe zu identifizieren, die Ursachen von Qualitätsproblemen zu analysieren und die Ressourcennutzung zu maximieren. Die Kombination von Echtzeit- und historischen Daten ermöglicht es, präzise Vorhersagemodelle zu erstellen, um zukünftige Produktionsmengen besser zu planen und die Lieferketten effizienter zu gestalten.

- Herausforderung im UNS: Die Herausforderung besteht darin, heterogene Datenformate zu vereinheitlichen und Abfragen über verschiedene Systeme hinweg zu ermöglichen. Hierbei geht es nicht um die Integration aller Big Data Informationen in den UNS, sondern gezielt relevante Informationen wie beispielsweise Sensordaten zu harmonisieren und verfügbar zu machen.

Ein effektives Architekturdesign muss daher skalierbare Speicherlösungen, eine performante Verarbeitung und intelligente Integrationsmechanismen kombinieren, um die verschiedenen Datenströme zusammenzuführen und eine ganzheitliche Sicht auf industrielle Prozesse zu ermöglichen.

Der #shared.UnifiedNamespace

Die Erweiterung des Unified Namespace hin zum #shared.UnifiedNamespace adressiert die genannten Herausforderungen. Dabei stehen die UNS Dezentralisierung und Differenzierung der Datenströme im UNS im Zentrum. Im Gegensatz zum traditionellen, zentralisierten UNS mit einem zentralen Massage Broker setzt der #shared.UNS damit auf eine dezentrale und anwendungsorientierte Architektur.

Was ist der #shared.UNS?

Während der UNS heute oftmals als zentraler Broker verstanden wird, baut der #shared.UNS auf einem dezentralen Architekturprinzip auf. Konkret bedeutet dies, dass mehrere spezialisierte UNS-Instanzen auf Edge-Ebene (#edge.UNS) existieren, die für verschiedene Anlagen und Produktionsumgebungen angepasst sind.

Jede #edge.UNS bildet die Struktur einer Anlage in einem standardisierten Datenmodell ab. Diese sind unabhängig von den individuellen Anforderungen der jeweiligen Anwendungsfälle. Für jeden Anlagentypen ist der #edge.UNS von der Struktur identisch, die übertragenen Kanäle (Desriptions) können sich aber unterscheiden. Dadurch wird eine hohe Skalierbarkeit und Wiederverwendbarkeit ermöglicht. Ein übergeordnetes System oder Broker kann diese lokalen Namespaces bei Bedarf und je nach Anwendungsfall aggregieren. Damit werden die Individualität und Dynamik typischer Anwendungsfälle nicht bereits im #edge.UNS Namespace abgebildet, wodurch die Komplexität bei der Erstellung und dem Betrieb des UNS erheblich reduziert wird. Das bewährte Prinzip der späten Variantenbildung steigert nicht nur die Effizienz und Flexibilität in der Produktion, sondern optimiert auch die Dateninfrastruktur für eine agile und skalierbare Nutzung.

Exkurs: Alternativ zu dezentralen #edge.UNS Instanzen könnte ein leistungsfähiges Broker-Cluster das gesamte Unternehmen zentral bedienen. Moderne MQTT-Broker lassen sich in Clustern betreiben, um Last auf mehrere Knoten zu verteilen und eine hohe Ausfallsicherheit zu gewährleisten. Diese zentralisierte Architektur kann auf Unternehmensebene die Administration vereinfachen, da eine einzige Instanz verwaltet wird. Herausfordernd sind jedoch mögliche Bandbreitenengpässe und erhöhte Latenzen zwischen Standorten – ein häufig kritischer Faktor insbesondere in Fertigungsumgebungen. Im Gegensatz hierzu werden durch lokale Instanzen geringe Latenz und Entkopplung auf Werksebene gewährleistet. Zudem lässt sich die Datenflut einschränken, da nicht alle Daten global übertragen werden müssen, sondern gefiltert werden können. Dieser verteilte Ansatz erfordert jedoch eine sorgfältige Definition der Namespaces, um eine konsistente Struktur sicherzustellen.

Neben dem #edge.UNS gibt es noch weiter Namespaces, wie z.B. #erp.UNS, #qms.UNS oder #hkd.UNS. Diese strukturieren die Daten aus den Enterprise Systemen, bzw. die verschiedenen Eingaben von Mitarbeitern.

Der "Human Knowledge Data“ UNS (#hkd.UNS) ist einer der wichtigsten Datenquelle, um zusätzliches Wissen (persönliches Wissen und persönliche Erfahrungen aus der Fertigung) in die Auswertungen zu integrieren.

Wir benötigen dieses Wissen der Experten!

Im #shared.UNS gibt es aus diesem Grund den #hkd.UNS: Nur das menschliche Wissen hilft uns z.B. Qualitätsdaten (#qms.UNS) richtig zu strukturieren und zu interpretieren. Nur Experten können Prozesse definieren, um z.B. Qualitätsdaten (#qms.UNS) mit den Daten aus den Anlagen (#edge.UNS) und dem ERP (#erp.UNS) zu verknüpfen, um daraus z.B. Schwachstellen in den Fertigungsprozessen abzuleiten.

Von der #edge.UNS teilt i-flow die Daten in relevante Datenströme auf. Einzelne Werte werden dabei automatisch gemäß einer vordefinierten Methode für spezifische Services optimiert und anschließend im jeweiligen Datenmodell veröffentlicht.

- #batch.UNS – für strukturierte, relationale Daten (z. B. BDE-Daten zur Berechnung des OEE).

- #dlh.UNS – für Big Data-Anwendungen, insbesondere Machine Learning und prädiktive Analysen (z. B. Prozessdaten für die Vorhersage der Bauteilqualität).

- #stream.UNS – für Echtzeit-Datenströme, die für unmittelbare Reaktionen und Monitoring-Anwendungen genutzt werden (z. B. Sensordaten zur Anlagenüberwachung).

Dies ermöglicht eine gezielte Integration relevanter Daten in den jeweiligen Anwendungsfall. Dabei können die einzelnen Services hinsichtlich Ihrer individuellen Anforderungen an Kritikalität, Latenz, Redundanz etc. optimiert werden. Ein Beispiel: Durch die Optimierung von Datenmenge und -format kann die Latenzzeit für spezifische Services deutlich reduziert werden. Dies kann bei produktionskritischen Anwendungsfällen, wie. z.B. der Rückverfolgbarkeit, von großer Bedeutung sein. Eine Anlage kann nicht weiter produzieren, solange die Prozess- und Qualitätsdaten für ein sicherheitsrelevantes Bauteil nicht in die Datenbank geschrieben sind.

Zur Anzeige und Auswertung der Daten, werden an die drei Daten-Services entsprechende Dashboards angebunden. Dashboards und Echtzeit-Analysen sind ein wesentlicher Bestandteil des #SharedUNS und haben schlussendlich zum Ziel, die Effizienz der Fertigung zu steigern. Durch die Visualisierung von Daten können Potenziale identifiziert und fundierte Entscheidungen getroffen werden.

Implementierung des #shared.UNS

Die Implementierung des #shared.UNS erfolgt in mehreren Schritten:

- Identifikation des Use Cases: Der erste Schritt ist die Identifikation von Use Cases für den #shared.UNS.

- Wirtschaftliche Betrachtung der Use Cases: Eine gründliche, gemeinsame wirtschaftliche Analyse der identifizierten Use Cases ist notwendig, um den potenziellen Nutzen und die Kosten der Implementierung zu bewerten.

- Definition der Architektur: Gemeinsam wird die zu realisierend Architektur entworfen, welche Komponenten der bestehenden OT/IT-Infrastruktur integriert. Soweit sinnvoll, können verschiedene OpenSource Software Produkte zum Einsatz kommen.

- Integration der Maschinen und Anlagen: Nach der Identifikation der Use Cases und der wirtschaftlichen Bewertung können die ersten Maschinen und Enterprise-Systeme in den UNS angebunden werden. Hierbei kann i-flow eingesetzt werden, um die Integration zu erleichtern und eine konsistente Datenübertragung zu gewährleisten.

- Datenstruktur für den #edge.UNS definieren: Ein wichtiger Schritt ist die Festlegung einer einheitlichen Datenstruktur nach einem Vorgehensmodell. Hierbei kann i-flow eingesetzt werden, um die Maschinendaten analog dem definierten Modell zu modellieren.

- Aufbau der ersten Daten-Services: Dies umfasst die Entwicklung und Implementierung von Daten-Services, welche die erfassten Daten verarbeiten, speichern und analysieren.

- Echtzeit-Datenanalyse und Visualisierung: Leistungsstarke Dashboards und Analysetools ermöglichen es, die erfassten Daten in Echtzeit zu visualisieren und zu analysieren.

Fazit

Die digitale Transformation der industriellen Produktion erfordert eine leistungsfähige und flexible Datenarchitektur. Der Industrial Unified Namespace (UNS) hat sich als entscheidende Lösung zur Vernetzung, Integration und Harmonisierung von Produktionsdaten etabliert.

Der #shared.UnifiedNamespace stellt eine Erweiterung des Unified Namespace (UNS) Konzepts dar und bietet Unternehmen eine effiziente und flexible Möglichkeit ihre Daten zu verwalten und Fertigungsprozesse zu optimieren. Durch die klare Trennung der Datenströme in Streaming-Daten, Batch Daten und Big Data können spezifische Anforderungen erfüllt und gleichzeitig die Komplexität der Datenstruktur erheblich reduziert werden.

Mit dem #SharedUNS erhalten Unternehmen eine modulare, leistungsfähige und zukunftssichere Datenstrategie, die sich nahtlos in bestehende Industrie 4.0-Konzepte integriert. Die strukturierte Implementierung über i-flow und TT PSC gewährleistet eine effektive Umsetzung.

Warum i-flow und TT PSC?

Erfahrung und Expertise: Mit 30 Jahren Erfahrung in der Automobilindustrie, einschließlich der Arbeit mit verschiedenen OEMs, entwickeln wir schon lange Standardlösungen für die Fertigung.

Langjährige Grundprinzipien: Unsere Methoden und Prinzipien sind seit Jahrzehnten bewährt und etabliert. Der #shared.UNS basiert auf diesen Erfahrungen und einer konstanten Weiterentwicklung der Systematiken und Technologien. Die Datentypen in der Fertigung sind nahezu gleichgeblieben, die Systematiken haben sich über die Jahre angepasst.

Enterprise-Umgebungen: Wir sind spezialisiert auf komplexe Enterprise-Umgebungen und kennen die spezifischen Herausforderungen.

Vertrautheit mit Datenmodellen: Wir kennen sehr viele Datenmodelle. Wie haben daraus kundenspezifischen Modelle abgeleitet und können diese effektiv anwenden.

Systematik und Werkzeugkasten: Unsere systematische Herangehensweise und unser erprobter Software- und Vorgehens-Werkzeugkasten gewährleisten effiziente Lösungen.

Kein Vendor Lock-in: Unsere Lösungen sind unabhängig von großen Legacy Softwarelösungen und nutzen vorhandene Systeme basierend auf Microservices. Wir bringen eine bewährte Systematik und ein strukturiertes Vorgehensmodell mit.

Datenexpertise: Unsere Experten für Datentypen und Factory DataOps optimieren Datenströme in Zusammenarbeit mit Produktionsexperten. Gleichzeitig kommen wir aus dem Shopfloor und verstehen die Herausforderungen, Prozesse und Menschen.

Basis und Zusammenarbeit: Wir bringen die grundlegende Infrastruktur mit, während Ihr Team die spezifischen Anpassungen zur Implementierung in Ihrer Umgebung gemeinsam mit uns vornimmt.

Skalierbarkeit und Belastungstests: Wir bieten skalierbare Lösungen und führen routinemäßig umfassende Belastungstests für durch.

Demo-Umgebung: Unsere Demo-Umgebung kann Ihre Daten verarbeiten und das System testen, um die Funktionalität zu demonstrieren

Über i-flow: i-flow ist ein Unternehmen für industrielle Software mit Sitz in Süddeutschland. Wir bieten produzierenden Unternehmen die weltweit intuitivste Software zur Vernetzung von Fabriken. Täglich über 400 Millionen Datenoperationen in produktionskritischer Umgebung demonstrieren die Skalierbarkeit der Software und das tiefe Vertrauen, das unsere Kunden in i-flow setzen. Unser Erfolg basiert auf enger Zusammenarbeit mit Kunden und Partnern weltweit, darunter namhafte Fortune-500-Unternehmen und Branchenführer wie Bosch.

Wir sind ein internationaler System Integrator mit Hauptsitz in München. Durch die Kombination unseres technologischen Wissens in den Bereichen Cloud, AI und Streaming mit unseren Produktions- und Datenkompetenz bieten wir optimierte Lösungen für Fertigungs- und Produktionsprozess an. Wir haben mehr als 30 Jahre Erfahrung im Bereich der Digitalen Fabrik. Zu unseren Kunden gehören großen deutschen Automobilhersteller und namhafte Unternehmen in der Zulieferindustrie.

[url=https://www.ttpsc.com]https://www.ttpsc.com[/url]

Transition Technologies PSC Germany GmbH

Dingolfinger Str. 15

81673 München

Telefon: +49 171 6152747

http://www.ttpsc.com

Senior Brand & Marketing Specialist – Regional

E-Mail: svenja.kratz@ttpsc.com

![]()